- 内容展现

- 最新评论

专访AMD高级副总裁 王启尚:未来,AI无处不在

2024年3月21日,AMD在北京成功召开了“AI PC创新峰会”。会后,PCEVA有幸采访到AMD高级副总裁,GPU技术与工程研发王启尚(David Wang)先生,对AMD AI领域的创新技术与生态布局进行了深入的探讨 ... ... ... ...

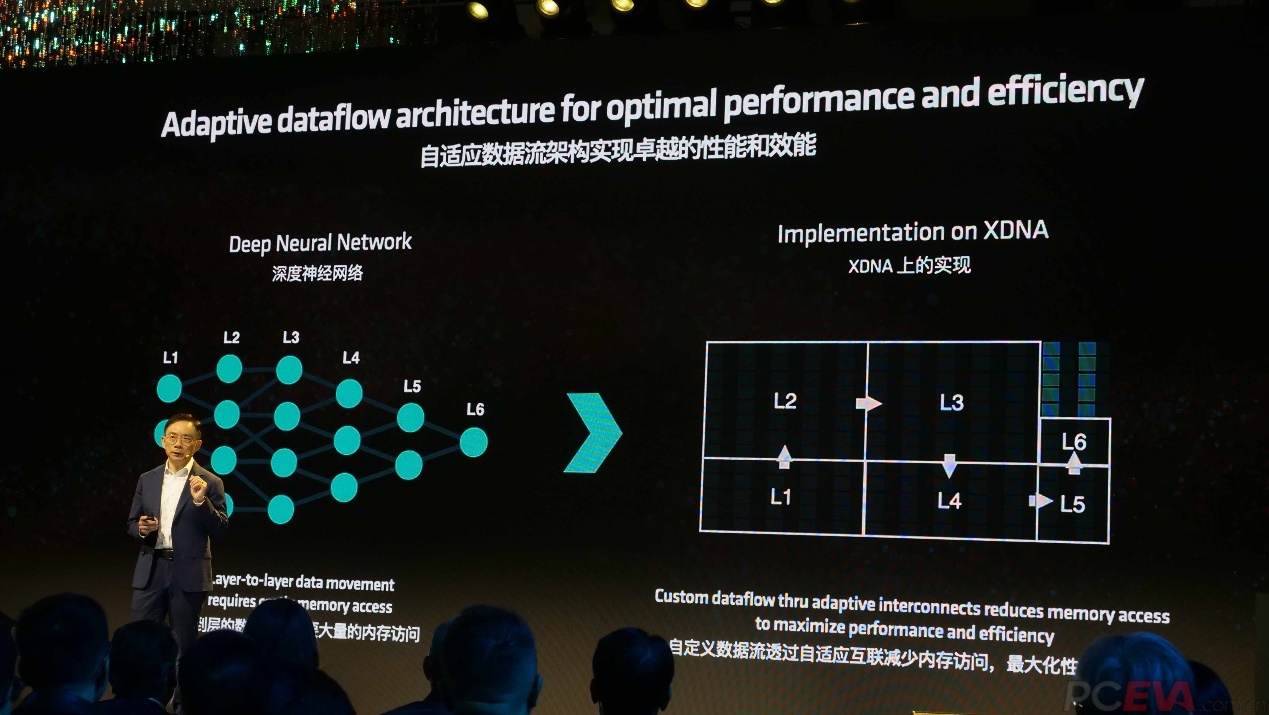

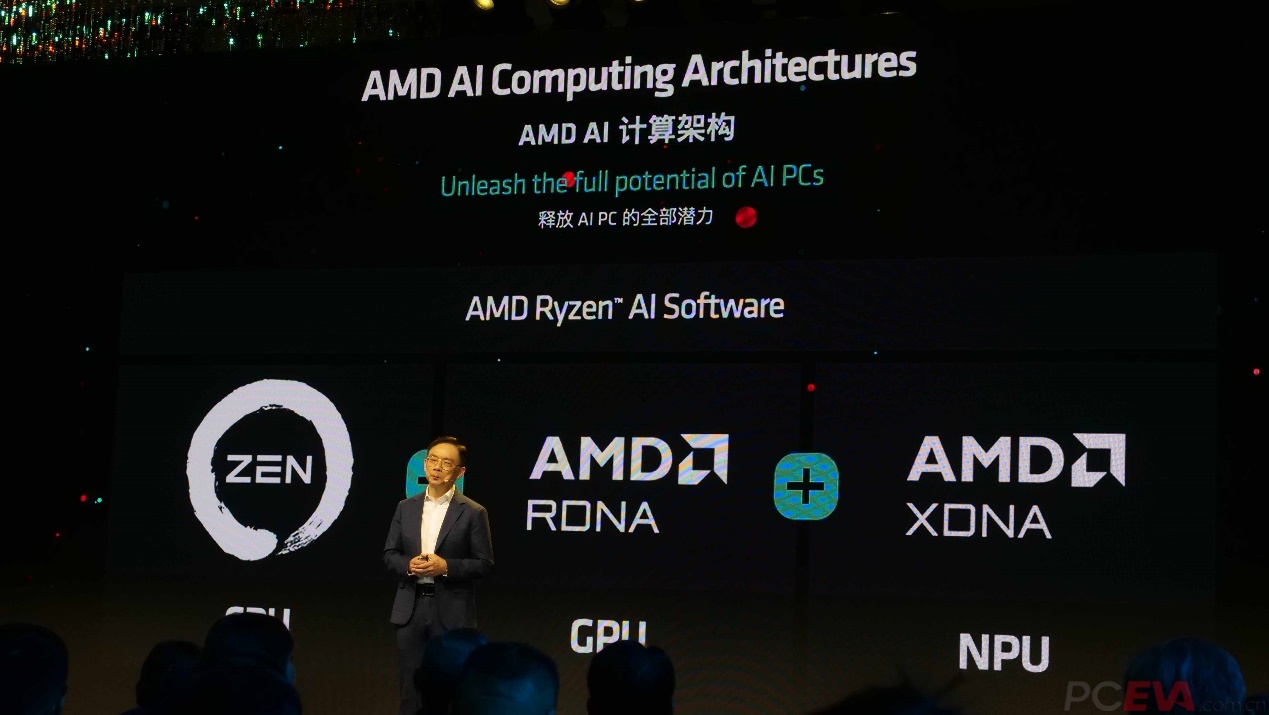

2024年3月21日,AMD在北京成功召开了“AI PC创新峰会”。会后,PCEVA有幸采访到AMD高级副总裁,GPU技术与工程研发王启尚(David Wang)先生,对AMD AI领域的创新技术与生态布局进行了深入的探讨。 AMD高级副总裁,GPU技术与工程研发 王启尚(David Wang)先生 王启尚(David Wang)先生负责 GPU 技术开发,包括架构、IP 和软件。他同时领导着 AMD 显卡 、数据中心 GPU、客户端和半定制业务的 SOC 工程研发。王启尚先生有超过 30 年的显卡和芯片工程研发经验,他带着深厚的技术专长和复杂芯片开发管理的骄人履历回到了AMD,是AMD超越老对手的功勋级人物。 回归 AMD 之前,王启尚先生在 2012 到 2018 年 1 月期间担任 Synaptics 公司的系统芯片工程研发高级副总裁,负责产品的芯片系统开发。在加入 Synaptics之前,他曾在 AMD 担任公司副总裁,负责 AMD 处理器产品(包括 GPU、CPU 和 APU)的图形 IP 和系统级芯片 (SoC) 开发。更早之前,他曾在 ATI、ArtX、Silicon Graphics、Axil Workstations 以及 LSI Logic 等公司担任过多个技术和管理职务。 随着AI技术从各种应用进入到我们的生活,一个崭新的AI PC时代即将到来。作为行业领军者的AMD已经开始提前布局,从去年锐龙7040发布打响了X86平台AI PC的第一枪,到现在的锐龙8040系列处理器、锐龙8000G系列处理器以及Radeon 7000系列显卡的全面开花,无不体现AMD走在了业界前端,但是仅有硬件与技术是不够的。王启尚认为:“任何应用都起始于技术,但是仅有技术是不够的,必须要配合软件和系统,技术的优势和价值才能得以发挥。所以,我们AMD与众多的AI行业生态伙伴、产业链伙伴开展深度合作,使得各个AI 产品在我们的应用和软件上运行,希望大家能够看到我们在此方面所付出的努力。” AI应用本地化是未来的方向 AI应用在最近两年呈现井喷式发展,相信不少用户或多或少听过或用过,比如ChatGPT、Stable Diffusion等生成式AI应用,而这些应用并不需要AI PC去处理,只需要普通PC甚至智能手机即可完成。在专访中,我们就这个问题咨询了王启尚先生,“推动这些用户将自己的PC更换成AI PC的主要推动力是什么?” 王启尚先生认为,AI PC支持在本地使用AI软件和工具,并且能够离线使用,如果你需要处理一些私人文件和照片,不希望上传到云端,AI PC就可以很好的满足需求。并且云端AI应用大多需要额外付费,而AI PC只需要你花费购买电脑的费用,不需要再为AI应用额外付费。基础的AI功能,例如做PPT时的AI模版生成,视频会议时的背景模糊、美颜等,AI PC已经内置了这些功能,不需要额外的软件去支持。 王启尚先生认为:“相比于通过云端AI处理方案,AI PC在本地进行任务处理,有效解决了延迟问题,提升了效率。它不需要像云端作业那样,等待上传和反馈。” 同时,AMD的XDNA架构的特殊设计,使其可以将架构区分成不同的区域,每个区域同时处理任务而不互不干扰,这一点是传统的GPU架构所不具备的能力。另外,XDNA的每瓦性能非常高,可以在低功耗的条件下执行AI工作任务,并且实现多任务并行处理,带给用户更优质的使用体验。 未来AI应用的发展方向,是从云端到边缘,进而到终端,AI技术对算力的要求会越来越高,无论是在云端还是终端。王启尚先生表示,AI技术未来的发展方向会更偏向“Hybrid AI”(混合式人工智能)方式。也就是通过数据中心来进行基础的大模型训练与推理,日常功能性的需求则通过AI PC在本地进行处理,不再需要将需求上传至云端。这样不但可以实现节能并降低延迟,还可以省去很多花费,又保护了隐私安全。 混合式人工智能是不错的解决方案 比较了解AMD产品的用户都知道,AMD已经在CPU和GPU产品中推出了搭载AI加速单元的产品,例如Radeon 7000系列显卡的AI加速单元、锐龙8040系列移动处理器以及锐龙8000G上的NPU,都是代表产品。那么,AI PC又是如何发挥出他们的优势?以及AI PC能否支持AI应用离线使用?PCEVA就这个问题咨询了王启尚先生。 王启尚先生表示,“目前Ryzen AI软件已经具备了定向编译能力,即可以将编译任务指定派发给CPU、GPU或NPU来执行。三者的运算单元各有其自身的优势。我们则希望可以实现智能化编译,通过对任务进行需求分析,根据硬件架构,智能化地分配给CPU、GPU或NPU,使得不同类型的编译需求分配给最适合的角色进行处理,使得CPU、GPU、NPU实现智能联动,充分发挥各自的优势能力。而除了绝对算力性能的提升,我们也必须要考虑到每瓦算力性能的平衡。” 人工智能技术的蓬勃发展,伴随着算力需求的高速增长,同时也带来了海量的用电需求,科技行业的巨头已经预警人工智能技术将面临“电力荒”问题。针对这一问题,王启尚先生认为:“我们既需要提升性能,也需要提高能效。正如我之前所提到的,并不是所有问题都需要通过大型数据中心解决,“混合式AI”则是一个不错的解决方案,让云端数据中心和本地AI PC各自执行相应的任务,这样不但能解决高功耗问题,还能够提升效率。” 展望未来 AMD最近为我们带来了FidelityFX Super Resolution(FSR)3.1版本,相信不少玩家非常关注这项技术的未来发展。AMD FSR技术与英伟达DLSS技术最大的不同在于其开源性以及适配性,你可以在全平台看到这项技术的应用,不受显卡、游戏、平台的限制。我们不禁好奇搭载AI加速单元的7000系显卡在FSR技术上效率会不会更高一些,还是说AI加速单元完全不参与FSR 3技术的运算中? 王启尚先生表示,目前AMD的FSR技术已经广泛覆盖到了行业各个领域,基本实现了我们当初的设计愿景。微软最近发布的DirectSR已经选择FSR作为他们的默认超级分辨率技术,这也充分印证了AMD FSR技术的优势。当然,这项技术也在不断完善和迭代中,我们会在有了明确的方向后,通过适当的时机跟各位分享。 最后,我们就“AI PC创新峰会”中提出的 Dataflow(数据流)架构进行了交流,王启尚先生深入浅出的讲解了Dataflow(数据流)架构的优势。王启尚先生表示:“传统的GPU架构的工作模式是把任务逐层传递,并且在显卡和内存之间反复执行“读”与“写”的动作,使得PC的功耗增大。而数据流架构可以并行执行“数据访问”和“数据计算”不需要逐级执行任务,这种架构可以消除指令操作导致的额外时间开销,避免了运算单元和外界显存之间的多次往返交互,从而使得每瓦性能得以提升。” 总结 2024年是AI元年,整个AI产业链迎来蓬勃发展,AMD作为AI产业链的龙头厂商无疑已经置身于这场变革中,而对于已经完成云端到终端部署的AMD来说,这场变革是一次大考,也是一个巨大的机会。 王启尚先生在这场专访中表达了AMD对这场变革的信心。专访的最后,他评价道:“未来,AI一定是无处不在的,而我相信AMD也有着独特的优势。无论在云端、边缘、终端,AMD都有着相应的产品部署,可以带给客户‘端到端’的优化体验。最后,我想说,我们对于中国市场是高度重视的,我们和本地的软件厂商、应用厂商、生态伙伴的深度合作大家有目共睹,我们希望能够把最好的本地化AI大模型、中模型、小模型提供给大家使用,并且带来更好的体验。” |

本文版权归 PCEVA,PC绝对领域,探寻真正的电脑知识 原作者所有 转载请注明出处

热门评论

商家促销

团购试用

原创精华

论坛热帖

367关注

29参与

329关注

28参与

365关注

21参与

346关注

21参与

252关注

11参与

251关注

9参与

362关注

4参与

155关注

4参与

112关注

3参与

473关注

3参与

精彩图文